WebUI

Ollama WebUI 已经更名为 Open WebUI. Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 WebUI,旨在完全离线操作。它支持各种 LLM 运行程序,包括 Ollama 和 OpenAI 兼容的 API。

Ollama WebUI 是一个革命性的 LLM 本地部署框架,具有类似 ChatGPT 的 Web 界面。让我们为您的 Ollama 部署的 LLM 提供类似 ChatGPT Web UI 的界面,只需按照以下 5 个步骤开始行动吧。

系统要求

Windows 10 64 位:最低要求是 Home 或 Pro 21H2(内部版本 19044)或更高版本,或者 Enterprise 或 Education 21H2(内部版本 19044)或更高版本。

Windows 11 64 位:家庭版或专业版 21H2 或更高版本,或者企业版或教育版 21H2 或更高版本。

WSL 版本 1.1.3.0 或更高版本。在 Windows 上打开 WSL 2 功能。

8 核 64 位处理器、16GB+ RAM、带有 4GB+ VRAM 的 Nvidia 显卡。

Docker Desktop,推荐安装最新版本。文章源自玩技e族-https://www.playezu.com/896949.html

显存内存

DeepSeek-R1 系列模型涵盖从轻量级到超大规模的多个版本,适用于不同的应用场景。了解各版本在不同量化精度下的显存和内存需求,有助于选择适合自身硬件配置的模型。文章源自玩技e族-https://www.playezu.com/896949.html

模型参数与量化精度的关系

模型的参数量决定了其基础大小,而量化精度(如 FP16、INT8、INT4)则影响每个参数所占用的存储空间。通过降低量化精度,可以显著减少模型的显存和内存占用,但可能会对模型性能产生一定影响。文章源自玩技e族-https://www.playezu.com/896949.html

以下是不同量化精度下,每个参数的存储需求:文章源自玩技e族-https://www.playezu.com/896949.html

FP16(16位浮点):每个参数占用 2 字节。

INT8(8位整数):每个参数占用 1 字节。

INT4(4位整数):每个参数占用 0.5 字节。文章源自玩技e族-https://www.playezu.com/896949.html

各版本模型的显存与内存占用估算根据上述量化精度,每个模型在不同精度下的显存和内存占用估算如下:文章源自玩技e族-https://www.playezu.com/896949.html

| 模型名称 | 参数量 | FP16 显存占用 | INT8 显存占用 | INT4 显存占用 | FP16 内存占用 | INT8 内存占用 | INT4 内存占用 |

|---|---|---|---|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5B | 3.0GB | 1.5GB | 0.75GB | 6.0GB | 3.0GB | 1.5GB |

| DeepSeek-R1-Distill-Qwen-7B | 7B | 14.0GB | 7.0GB | 3.5GB | 28.0GB | 14.0GB | 7.0GB |

| DeepSeek-R1-Distill-Llama-8B | 8B | 16.0GB | 8.0GB | 4.0GB | 32.0GB | 16.0GB | 8.0GB |

| DeepSeek-R1-Distill-Qwen-14B | 14B | 28.0GB | 14.0GB | 7.0GB | 56.0GB | 28.0GB | 14.0GB |

| DeepSeek-R1-Distill-Qwen-32B | 32B | 64.0GB | 32.0GB | 16.0GB | 128.0GB | 64.0GB | 32.0GB |

| DeepSeek-R1-Distill-Llama-70B | 70B | 140.0GB | 70.0GB | 35.0GB | 280.0GB | 140.0GB | 70.0GB |

| DeepSeek-R1 671B | 671B | 1342.0GB | 671.0GB | 335.5GB | 2684.0GB | 1342.0GB | 671.0GB |

参数说明:

显存占用:指模型在 GPU 上运行时所需的显存。

内存占用:指模型在 CPU 上运行时所需的内存,通常为显存占用的两倍,用于加载模型和计算缓冲。文章源自玩技e族-https://www.playezu.com/896949.html

解释说明:

实际的显存和内存占用可能因模型架构、批处理大小(batch size)、序列长度(sequence length)以及推理框架等因素而有所变化。

采用量化技术(如 INT8 或 INT4)可以显著降低显存和内存占用,但可能会对模型的精度产生一定影响。

在 CPU 上运行大型模型可能导致推理速度较慢,建议根据硬件配置选择适当的模型版本。

选择适合的模型版本

在选择模型版本时,应综合考虑硬件配置、应用需求和性能要求。对于资源有限的环境,建议选择参数量较小或经过量化的模型版本。而对于高性能需求的应用,可考虑部署参数量较大的模型,但需确保硬件资源充足。文章源自玩技e族-https://www.playezu.com/896949.html

通过合理选择模型版本和量化精度,可以在满足应用需求的同时,充分利用现有硬件资源。文章源自玩技e族-https://www.playezu.com/896949.html

安装使用:方式一

在 Windows 计算机上深入研究 Ollama 和 Ollama WebUI 是进入人工智能和机器学习世界的激动人心的旅程。本详细指南将引导您完成每个步骤并提供示例以确保顺利启动。文章源自玩技e族-https://www.playezu.com/896949.html

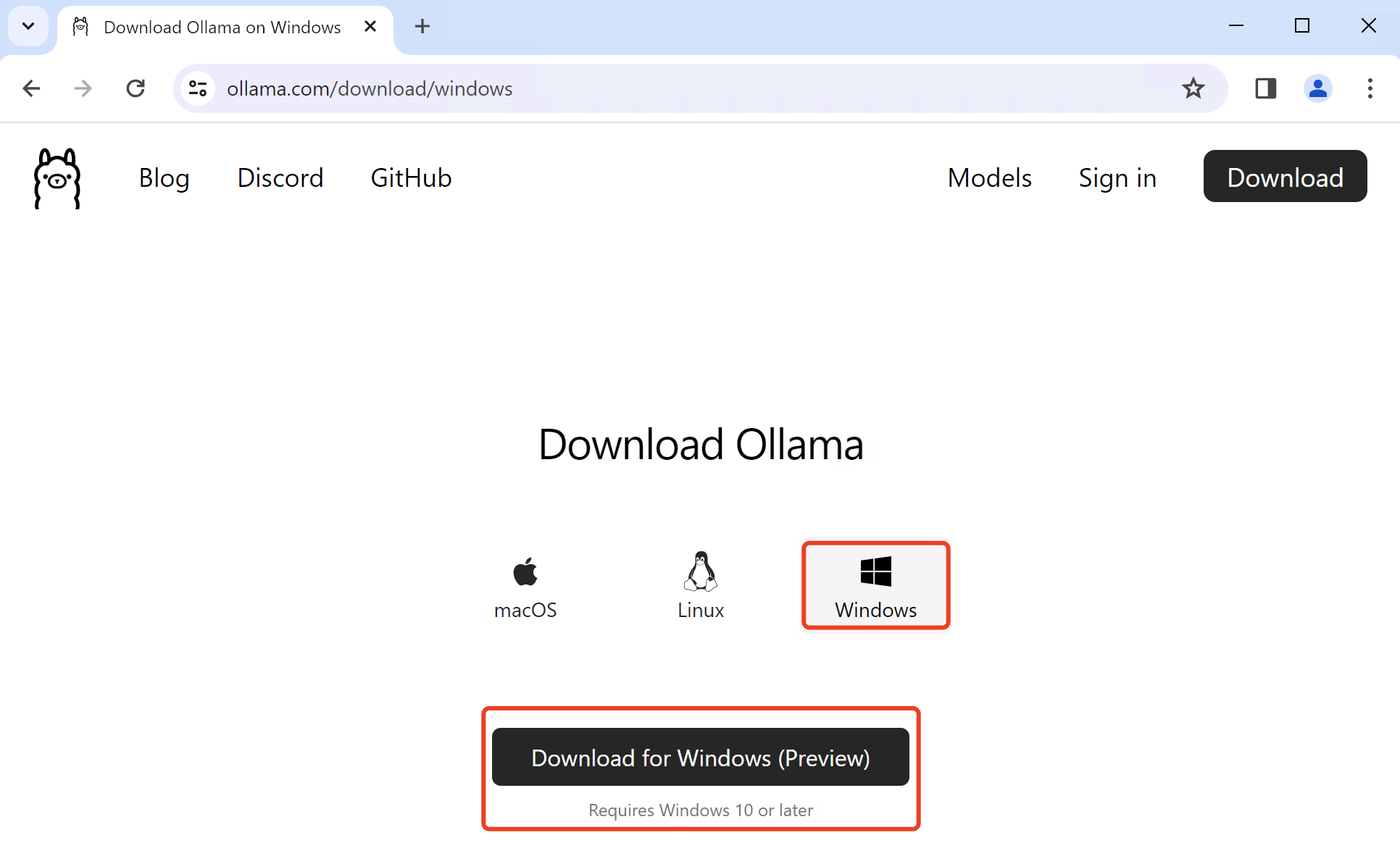

第 1 步 - 安装 Ollama

点击这里 https://ollama.com/download/windows 下载 Ollama ,然后右键单击下载的 OllamaSetup.exe 文件并以管理员身份运行安装程序。安装完成后,Ollama 就可以在您的 Windows 系统上使用。桌面底部的托盘区域将添加一个 Ollama 图标。

要运行 Ollama 并开始利用其 AI 模型,您需要使用 Windows 上的终端。这里先跳过,看看如何安装WebUI以获得更好的体验。

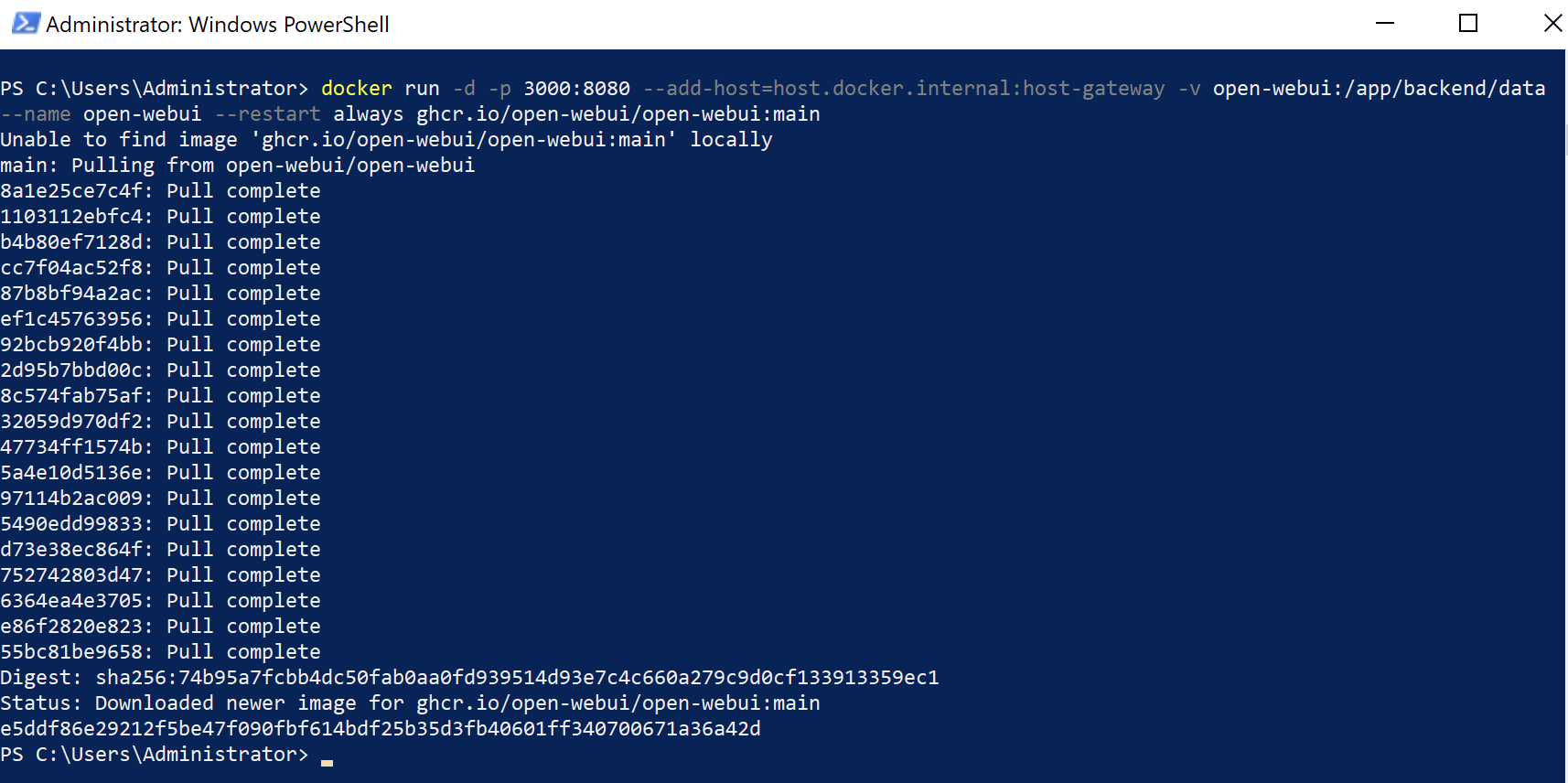

第 2 步 - 安装 Ollama WebUI

运行以下 docker 命令以在本地计算机上部署 llama-webui docker 容器。如果您的计算机上有 Ollama,请使用以下命令:

要连接到另一台服务器上的 Ollama,请将 OLLAMA_BASE_URL 更改为服务器的 URL。因此,如果 Ollama 在不同的服务器上,请使用以下命令:

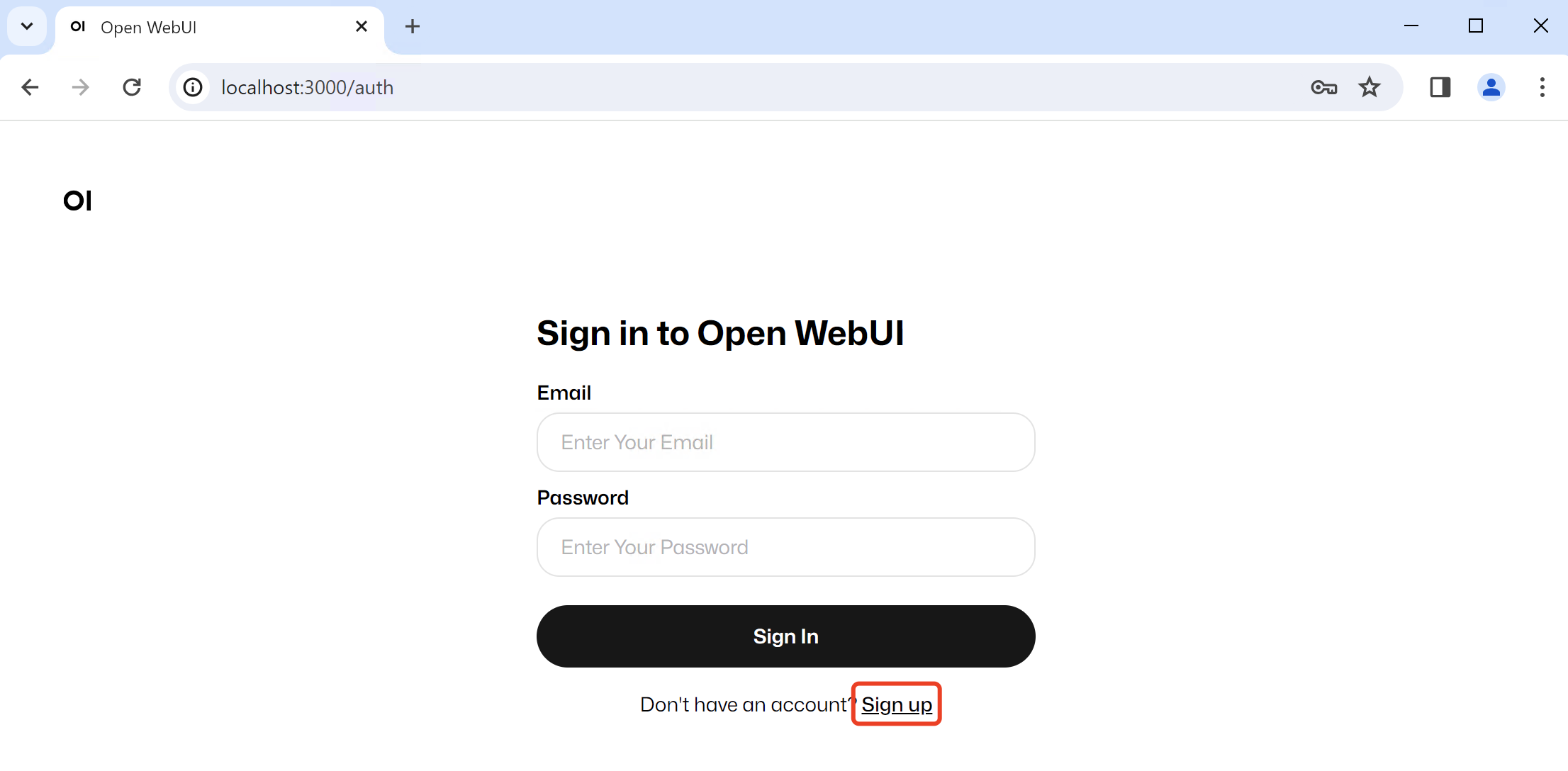

第 3 步 - 登录打开 WebUI

安装完成后,您可以通过http://localhost:3000访问Open WebUI。第一次您需要点击“注册”进行注册。

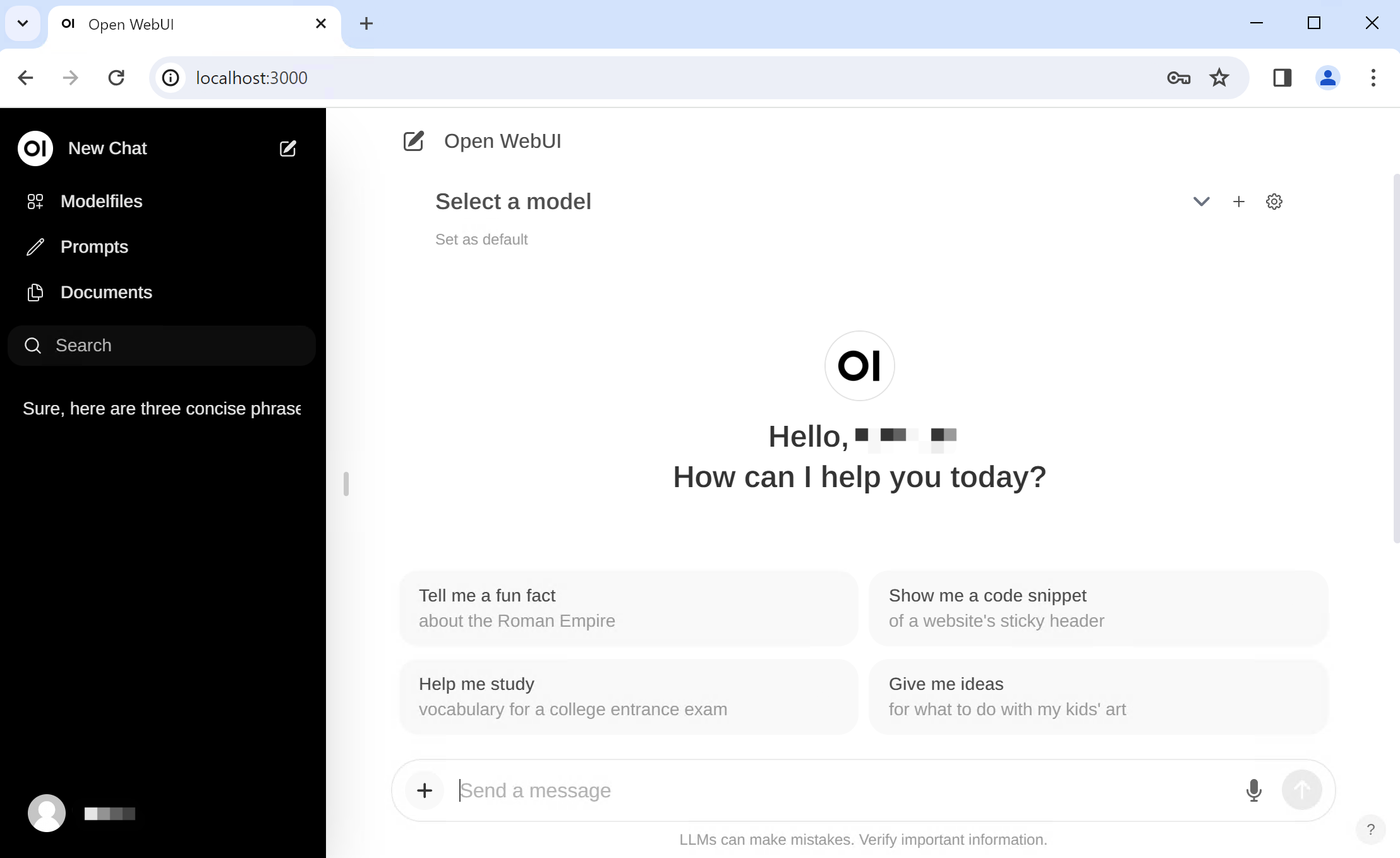

注册后,您将被引导至 ollama-webui 的主页。

运行以下命令:

New-NetFirewallRule -DisplayName "Allow Port 3000" -Direction Inbound -Action Allow -Protocol TCP -LocalPort 3000

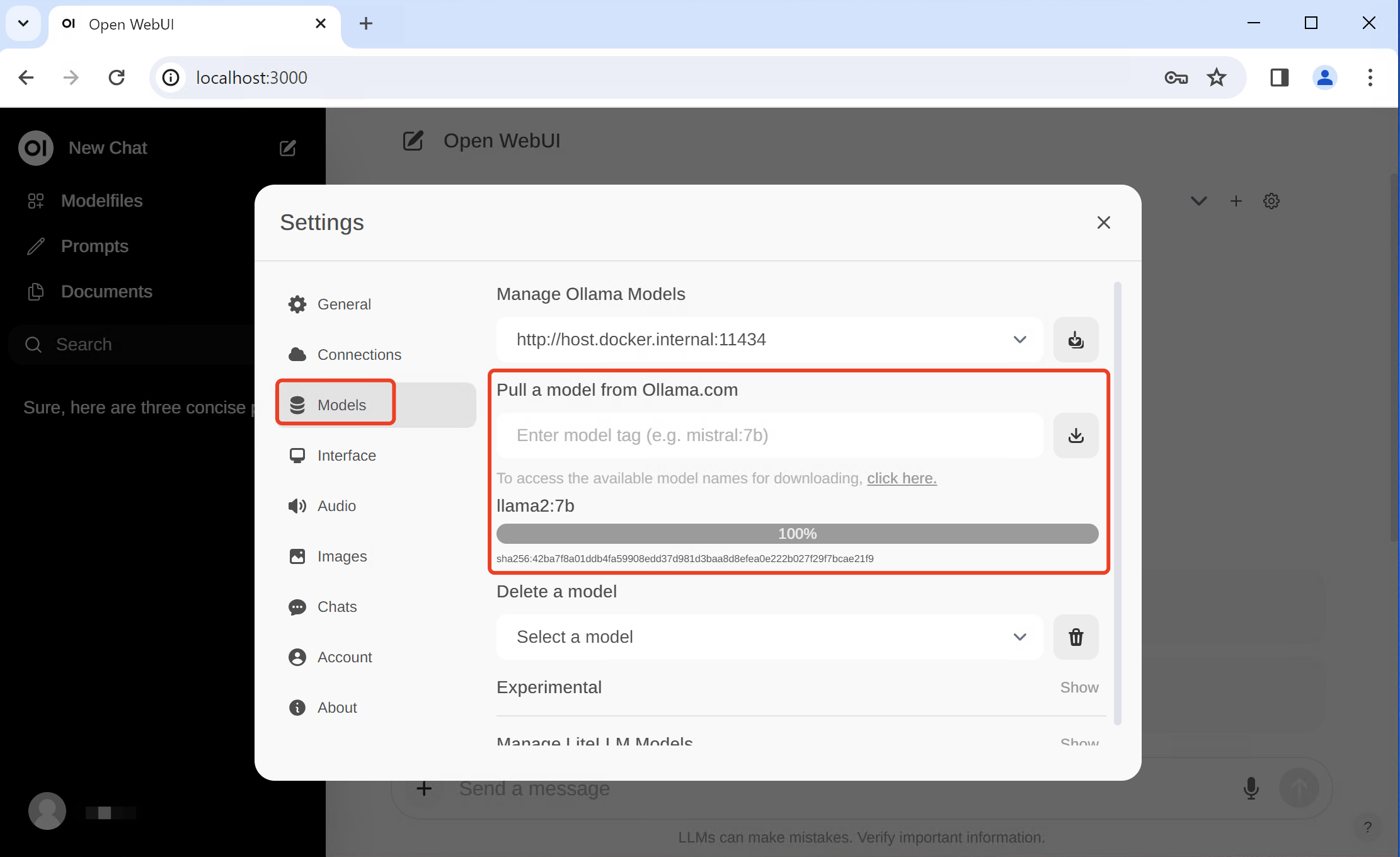

第 4 步 - 从 Ollama.com 提取模型

点击右上角设置图标,打开设置窗口,如下图,输入型号标签(如llama2:7b, gemma:2b),点击右侧下载按钮,等待型号待下载。

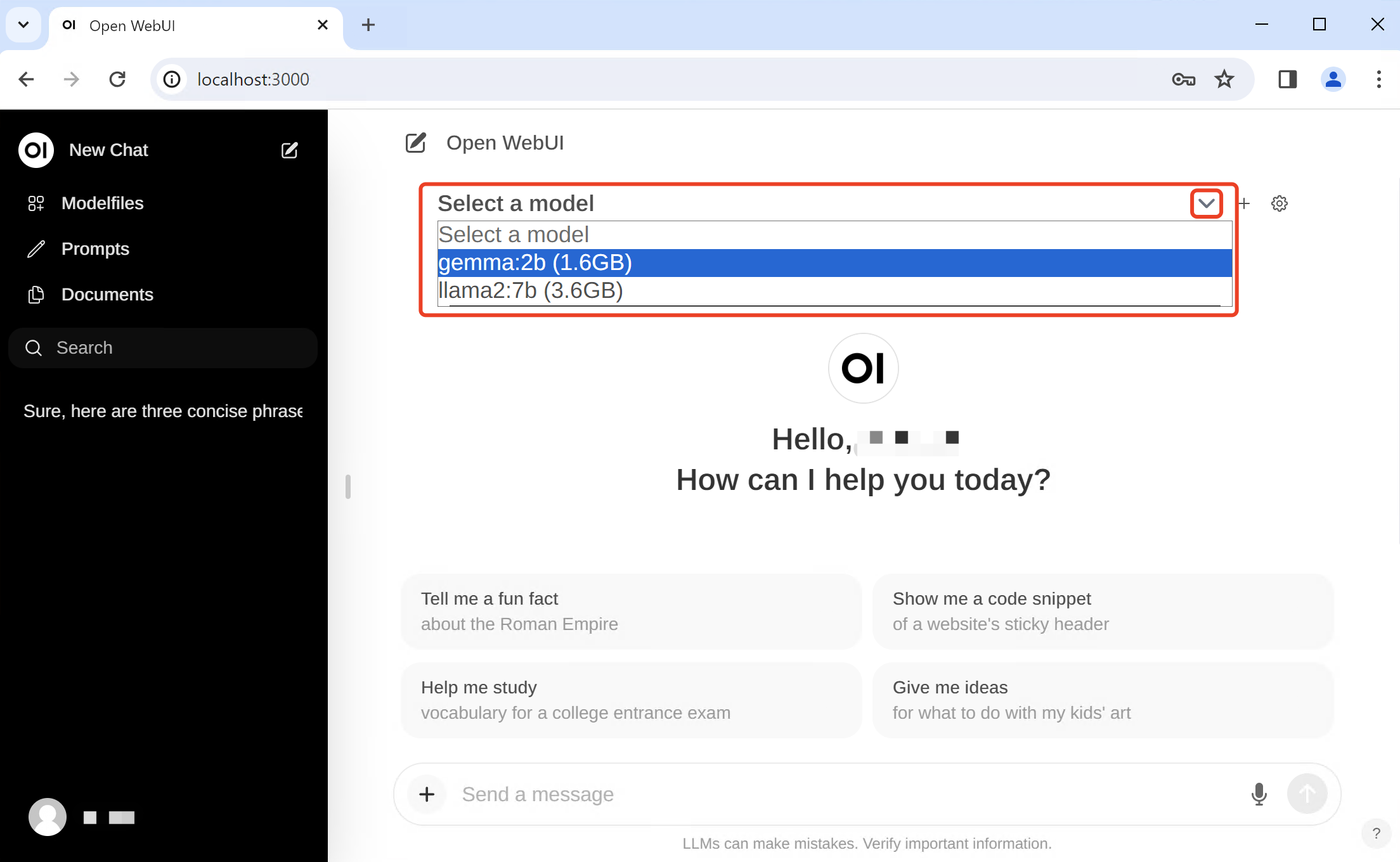

第 5 步 - 选择型号并享受 AI 聊天

如下图,我们已经下载了gemma:2b和llama2:7b模型,选择gemma:2b。

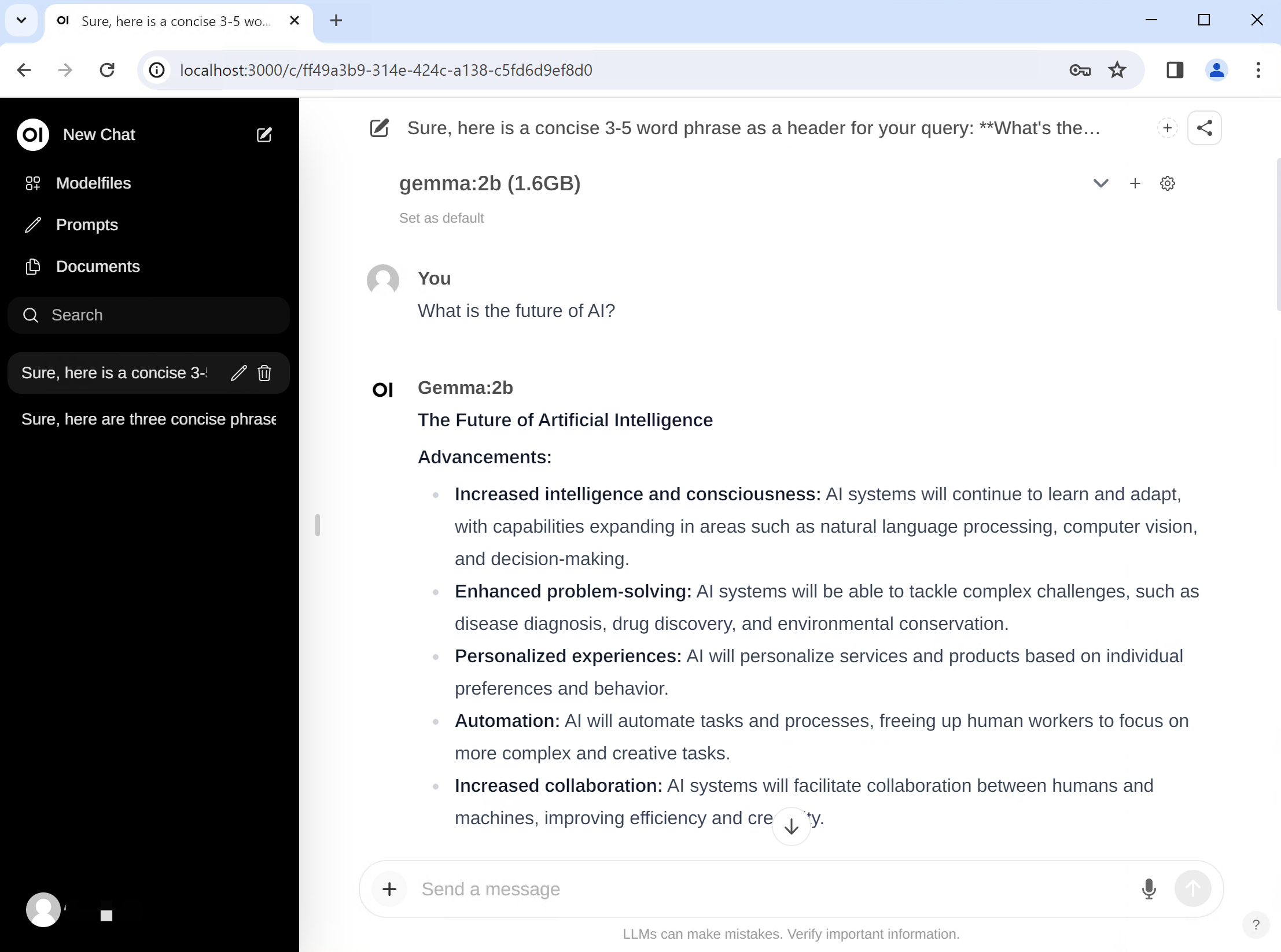

输入提示词“What is the future of AI?”并按 Enter 发送消息。

安装使用:方式二

由于我们安装的时候是命令窗口的,因此我们每次打开的时候都需要运行ollama run deepseek-r1:8b,然后关闭,好多小伙伴都不会,因此我们还需要安装图形化

第 1 步 - 安装图形界面

我们输入网站https://cherry-ai.com/download,然后点击立即下载,下载完成后我们由于是window系统,因此我们点击windows版本的安装。全程下一步即可。

第 2 步 - 配置图形界面

我们点击坐下红圈的位置进行设置,然后选择Ollama,api地址输入http://localhost:11434/v1/,然后api密钥不用管,继续点击管理按钮,然后我们点击添加,这样我们就已经把deepseek模型添加进去了这样我们就已经把deepseek模型添加进去了

这样我们就可以使用这个模型了(注意此处我们要在红圈位置点击我们安装的模型,要不然就会提示错误)

进阶教程

局域网络访问

默认安装方式无法支持局域网络的其他设备访问,下面就教大家如何将模型开放给局域网络的其他用户使用。类似于上面的模型下载的环境变量的设置,windows下Ollama大模型网络访问及GPU使用也是通过环境变量

放行相关端口

服务相关命令

ollama serve #启动ollama ollama create #从模型文件创建模型 ollama show #显示模型信息 ollama run #运行模型 ollama pull #从注册表中拉取模型 ollama push #将模型推送到注册表 ollama list #列出模型 ollama cp #复制模型 ollama rm #删除模型 ollama help #获取有关任何命令的帮助信息

其他服务命令

echo $env:OLLAMA_GPU_LAYER #查看环境变量是否生效(windows) nvidia-smi -L #查看GPU设备的id nvidia-smi #查看cuda版本的ollama占用 ollama ps #在推理时使用Ollama ps 即可查看负载情况

强制算力服务

总结

在本教程中,我们介绍了 Windows 上的 Ollama WebUI 入门基础知识。 Ollama 因其易用性、自动硬件加速以及对综合模型库的访问而脱颖而出。Ollama WebUI 更让其成为任何对人工智能和机器学习感兴趣的人的宝贵工具。

原创声明:本文章为原创内容,所有文章均由博主亲自撰写,严格遵循原创原则。我们承诺不使用任何人工智能生成的内容,所发布的每一篇文章都经过深思熟虑,旨在为读者提供真实、有价值的观点和信息。我们坚信原创才是知识分享的根本,致力于为广大读者呈现最具真实性和独特性的文章。感谢您的支持与关注,欢迎持续关注我们的原创内容。

湖北省天门市 3F

我同事也在本地建立deepseek服务器,自用的话,响应速度没得说,但是论综合效果,还是联网版的强。

阿三因为电脑配置有限,加上囊中羞涩,没有考虑过研究,今天来过,就是纯围观,膜拜~

北京市 B1

@ 林三 3060应该就可以跑起来吧。低配版确实有点人工智障。

安徽省合肥市 2F

我都评论了,还是看不到隐藏内容,郁闷

广东省深圳市 B1

@ 奥里给 感谢反馈,目前问题已修复,请重新尝试刷新。

安徽省合肥市 1F

学习下,感谢兄弟